Le cours introduit les outils mathématiques permettant de modéliser des données en grande dimension, en lien avec la physique statistique et la théorie de l’information. La physique statistique montre que les lois macroscopiques résultent de la statistique des interactions de particules microscopiques. Ceci est capturé par l’énergie et l’entropie du système.

La théorie de l’information donne une définition mathématique de l’entropie d’une distribution de probabilité qui est liée à la taille d’un code optimal des données. La modélisation par chaîne de Markov définit des modèles d’évolutions temporelles, y compris pour l’augmentation de l’entropie.

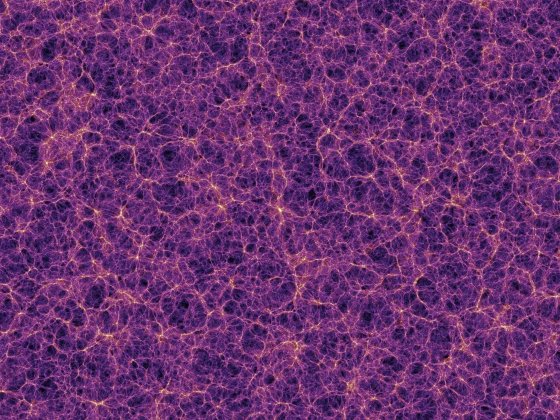

Le principe d’entropie maximum permet de modéliser des données de grande dimension, avec des distributions de probabilités spécifiées par un nombre limité de paramètres. Ils définissent une énergie de Gibbs comme en physique statistique. On peut construire des distributions non gaussiennes, dont les propriétés sont capturées par une séparation d’échelles, en caractérisant les interactions d’échelles. Le cours étudie des applications pour la modélisation et la génération de champs physiques et d’images.